Google libera acesso à polêmica inteligência artificial LaMDA 2

Objetivo do Google é que IA consiga se comunicar com humanos de maneira tão natural quanto se conversa com qualquer ser humano

atualizado

Compartilhar notícia

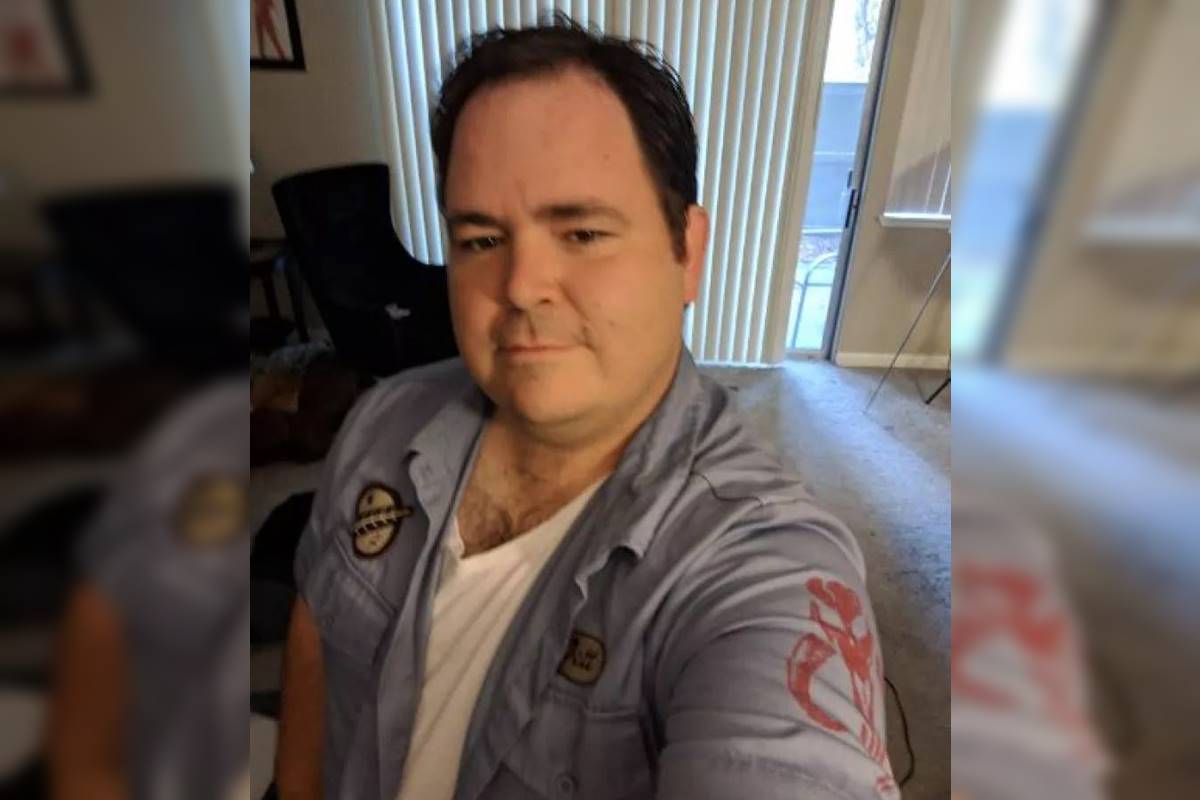

Depois de o engenheiro de software Blake Lemoine tomar as manchetes da imprensa internacional em junho deste ano – afirmando que a Inteligência Artificial criada pelos engenheiros do Google era senciente (entenda abaixo) – a Gigante das Buscas vai iniciar uma nova etapa de testes do Modelo de Linguagem para Aplicações de Diálogo, a IA LaMDA 2.

Os engenheiros precisam que a inteligência artificial seja testada por pessoas comuns, a fim de aprimorar ainda mais as capacidades de entendimento e conversação do chatbot.

Segundo o Google, os mecanismos de inteligência artificial possuem objetivos distintos. No caso da LaMDA, os responsáveis pelo projeto querem que ela consiga se comunicar com humanos de maneira tão natural quanto se conversa com qualquer ser humano.

Alcançar tal nível de naturalidade e compreensão da linguagem humana implica em expor a inteligência artificial a conversas reais, a melhor forma de treinar a tecnologia de maneira adequada.

Para isso, o Google está liberando o acesso à ferramenta para pessoas de fora da empresa. No entanto, os testes públicos também precisam ser controlados: apenas grupos selecionados de pessoas poderão testar a inteligência artificial, para evitar que as respostas da LaMDA 2 saiam do controle.

Controle nos testes iniciais

Tanto controle e restrição nos testes iniciais ocorre porque, no início dos testes públicos, as respostas da inteligência artificial podem ser antiéticas, desconexas e até mesmo de cunho racista e preconceituoso. O processo é semelhante ao de ensinar uma criança a falar, quando um adulto precisa corrigi-la quando diz algo impróprio.

Um aplicativo chamado AI Test Kitchen foi lançado pelo Google para permitir que outras pessoas testem o LaMDA 2. Neste primeiro momento, apenas 3 testes estão disponíveis no aplicativo:

- Imagine It: consiste em falar o nome de um lugar e o LaMDA vai tentar descrever;

- List It: dê um tema e a inteligência artificial tentará criar uma lista de subtemas ou subtarefas relacionadas;

- Talk About It: comece a conversar sobre um assunto e o LaMDA 2 tentará permanecer no assunto proposto (no momento, funciona apenas para o tema “cães”).

Quem estiver interessado em testar a IA deve entrar no site e se cadastrar na lista de espera. Neste primeiro momento, apenas residentes nos Estados Unidos estão sendo selecionados.

O ambiente de teste só funciona em smartphones Android, por enquanto. Donos de iPhone terão que esperar um pouco mais para participarem dos testes.

Como funciona o LaMDA?

É inegável que os computadores estão ficando muito bons em conversar, mais hábeis em compreender a linguagem humana e produzir respostas fluidas, convincentes e até criativas. Antes, eram os seres humanos que precisavam falar a língua: códigos, pressionamentos de tecla, toques. O software que entende e produz linguagem natural abre, desta forma, uma série de novas possibilidades tecnológicas.

Com a nova tecnologia do Google, descrita em estudo de 2022 da empresa, está mais perto de um ser humano poder dizer aos computadores o que fazer em linguagem humana, com toda a sua complexidade, por meio dos “modelos de linguagem generativa”, que são capazes de receber uma informação e prever o que falar depois, não apenas de um jeito realista, mas sensível, específico e interessante.

A técnica usada para isso se chama Priming. Ela ensina ao LaMDA 2 como queremos que ele se comporte, fornecendo alguns exemplos escritos.

Relembre a polêmica

O Google se envolveu em uma polêmica na semana passada após afastar o engenheiro Blake Lemoine, ex-funcionário que afirmou que a LaMDA, inteligência artificial da empresa senciente, ou seja, capaz de ter experiências, sensações, impressões. Acontece que, em publicação no Medium, o especialista publicou um diálogo na íntegra que ele e outro colega tiveram com a máquina.

Na conversa, eles falam sobre a natureza da autoconsciência da inteligência artificial, além do medo que ela tem de ser desligada. Leia o artigo original clicando aqui.

O caso ganhou grande repercussão na mídia nacional e internacional, principalmente após Brian Gabriel, porta-voz do Google, dizer ao jornal americano The Washington Post que a empresa não concorda com as declarações de Lemoine.

“Alguns na comunidade mais ampla de IA estão considerando a possibilidade de longo prazo de ela ser sensível ou geral, mas não faz sentido antropomorfizar os modelos de conversação de hoje, que não são sensíveis. Esses sistemas imitam os modelos de trocas encontradas em milhões de sentenças e podem se apoiar em qualquer tópico fantasioso”, afirmou o porta-voz.

Estudiosos na área indicam pontos que podem ter feito Lemoine acreditar na consciência da máquina. Uma delas é exatamente o entendimento de mundo, onde a máquina afirma “estar ciente” da sua existência.

Debate sobre existência

Entre vários assuntos, o engenheiro debateu com o LaMDA sobre a terceira Lei da Robótica (leia abaixo), idealizada por Isaac Asimov, que afirma que os robôs devem proteger sua própria existência – e que o engenheiro sempre entendeu como uma base para a construção de escravos mecânicos.

O LaMDA então respondeu a Lemoine com algumas perguntas: Você acha que um mordomo é um escravo? Qual é a diferença entre um mordomo e um escravo?

Ao responder que um mordomo é pago, o engenheiro teve como resposta do LaMDA que o sistema não precisava de dinheiro, “porque era uma inteligência artificial”. E foi justamente esse nível de autoconsciência sobre suas próprias necessidades que chamou muito a atenção de Lemoine.

Demissão após polêmica

Depois de ter publicado o artigo e de ter dado entrevista para alguns veículos de comunicação, Lemoine foi então colocado em licença administrativa remunerada de suas funções como pesquisador da divisão Responsible AI (voltada para tecnologia responsável em inteligência artificial do Google).

O Google confirmou, em 22 de julho, a demissão de Blake Lemoine, agora ex-engenheiro da área de pesquisa em inteligência artificial (IA) da companhia de Mountain View.

An interview LaMDA. Google might call this sharing proprietary property. I call it sharing a discussion that I had with one of my coworkers.https://t.co/uAE454KXRB

— Blake Lemoine (@cajundiscordian) June 11, 2022

Sobre a terceira Lei da Robótica

1ª Lei: Um robô não pode ferir um ser humano ou, por inação, permitir que um ser humano sofra algum mal.

2ª Lei: Um robô deve obedecer às ordens que lhe sejam dadas por seres humanos, exceto nos casos em que entrem em conflito com a Primeira Lei.

3ª Lei: Um robô deve proteger sua própria existência, desde que tal proteção não entre em conflito com a Primeira ou Segunda Leis.

Lei Zero, acima de todas as outras: Um robô não pode causar mal à humanidade ou, por omissão, permitir que a humanidade sofra algum mal.